Für die Entwicklung funktionaler Programmierparadigmen in Java markierte die in Java 8 eingeführte Stream-API einen entscheidenden Schritt. Mit Java 24 hat sich die Stream-Verarbeitung konsolidiert und stellt mittlerweile ein zentrales Werkzeug für die deklarative Datenverarbeitung dar. Dabei handelt es sich bei einem Stream nicht etwa um eine alternative Form von Collection, sondern um ein abstraktes Konzept, das eine potenziell unendliche Sequenz von Daten beschreibt, die durch eine Pipeline von Operationen transformiert und verarbeitet wird. Während eine Collection eine Datenstruktur ist, die Daten speichert, fungiert ein Stream als Träger eines Rechenmodells: Er speichert keine Daten, sondern ermöglicht die Beschreibung von Datenflüssen.

Anzeige

Jede Stream-Verarbeitung lässt sich in drei logisch getrennte Phasen gliedern. Ausgangspunkt ist stets eine Quelle – dies kann eine Collection, ein Array, ein I/O-Channel oder eine erzeugte Struktur wie Stream.generate(...) sein. Auf die Quelle folgen eine Reihe von Intermediate Operations, die den Stream transformieren, filtern oder sortieren. Diese Operationen erfolgen "lazy", das heißt, sie werden nicht sofort ausgeführt, sondern lediglich registriert. Erst durch eine abschließende Terminal Operation wie forEach , collect oder reduce , wird die Ausführung ausgelöst und die gesamte Pipeline konkretisiert. Das Lazyness-Prinzip erlaubt es der JVM, Operationen zu optimieren, zu fusionieren oder sogar zu eliminieren, falls sie keine Auswirkungen auf das Endergebnis haben.

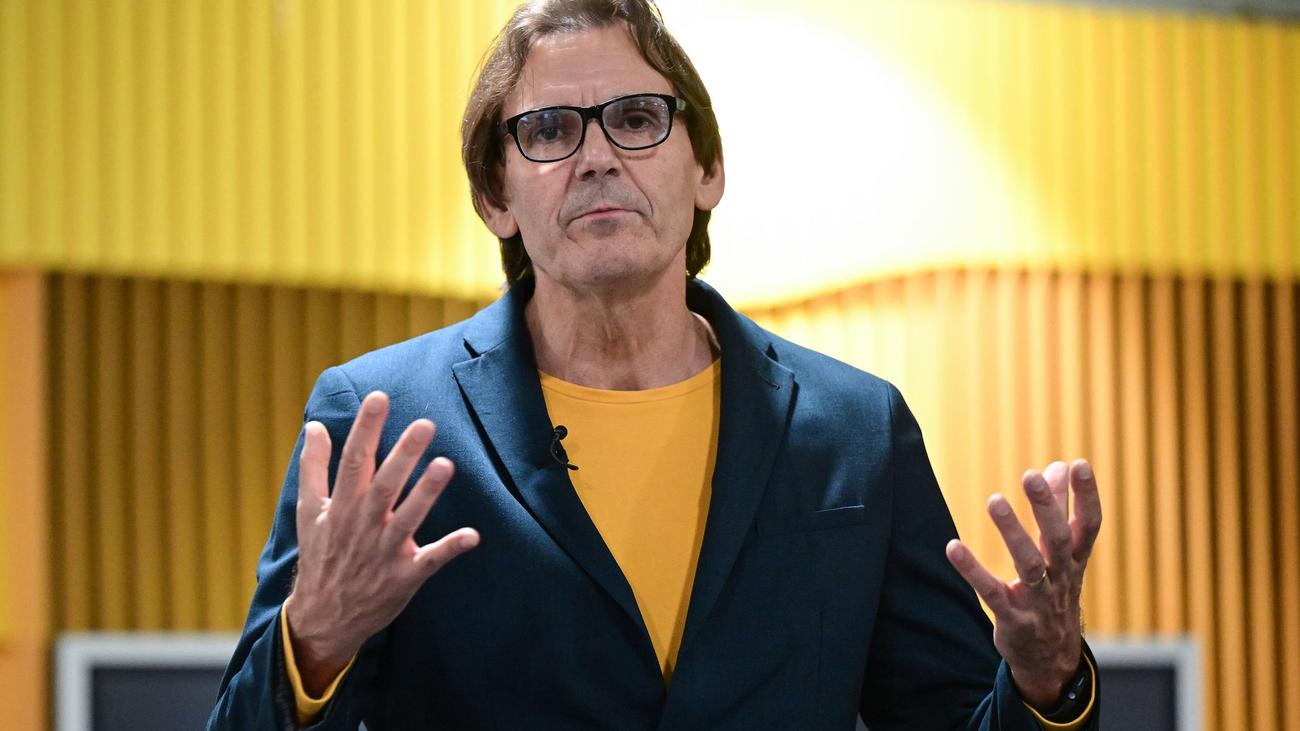

Core Java – Sven Ruppert Seit 1996 programmiert Sven Java in Industrieprojekten und seit über 15 Jahren weltweit in Branchen wie Automobil, Raumfahrt, Versicherungen, Banken, UN und Weltbank. Seit über 10 Jahren ist er von Amerika bis nach Neuseeland als Speaker auf Konferenzen und Community Events, arbeitete als Developer Advocate für JFrog und Vaadin und schreibt regelmäßig Beiträge für IT-Zeitschriften und Technologieportale. Neben seinem Hauptthema Core Java beschäftigt er sich mit TDD und Secure Coding Practices.

Ein grundlegendes Merkmal der Stream-Architektur ist ihre Einmaligkeit. Ein Stream lässt sich genau einmal konsumieren. Sobald eine Terminal Operation ausgeführt wurde, ist der Stream erschöpft. Daraus folgen tiefgreifende Konsequenzen für das Design von Stream-basierten Algorithmen, da Entwicklerinnen und Entwickler mit Bedacht entscheiden müssen, wann und wo eine Pipeline evaluiert wird. Im Vergleich zu wiederverwendbaren Datencontainern wie Listen verlangt dies ein Umdenken hin zu zielgerichteter (fluent) Verarbeitung.

Die Struktur einer Stream-Pipeline folgt dabei einem wohldefinierten Aufbau. Sie beginnt mit der Definition der Datenquelle, ergänzt durch eine Sequenz von Zwischenoperationen und mündet in eine abschließende Consumer-Aktion. Unter der Haube erkennt und analysiert die JVM diese Struktur und führt eine Vielzahl von Optimierungen durch. Beispielsweise kann die JVM Operationen wie map und filter zusammenfassen (Operation Fusion), parallele Ausführung auf geeigneten Quellen aktivieren oder redundante Berechnungen vermeiden. Diese Optimierungsmöglichkeiten sind nur durch die deklarative Natur von Streams möglich und unterstreichen den Unterschied zu imperativem Code mit klassischen Schleifen.

In Java bleibt die Stream-API ein Schlüsselelement für moderne, ausdrucksstarke und nebenläufige Datenverarbeitung. Ihr Verständnis setzt jedoch ein tiefes Bewusstsein für die Unterschiede zur konventionellen Sammlungshierarchie voraus – insbesondere im Hinblick auf Lazyness, einmalige Verwendung und JVM-gestützte Optimierungen, die Streams zu einem mächtigen Werkzeug im Repertoire jedes Java-Entwicklers machen.

Erste Schritte mit Streams in Java

Anzeige

Die ersten Schritte mit der Stream-API in Java erfordern ein grundlegendes Verständnis funktionaler Programmierkonzepte sowie der Art und Weise, wie Java diese Konzepte innerhalb einer objektorientierten Sprache integriert. Streams ermöglichen es, Datenflüsse deklarativ zu beschreiben, wobei der Fokus nicht auf dem Wie, sondern auf dem Was der Datenverarbeitung liegt. Diese Umstellung von imperativer zu deklarativer Denkweise bildet das Fundament für ein modernes, prägnantes und zugleich ausdrucksstarkes Programmiermodell.

Ein typischer Einstiegspunkt in die Stream-Verarbeitung ist die Umwandlung bestehender Datenstrukturen wie etwa List- oder Set-Instanzen in einen Stream. Dies geschieht mit der Methode stream() , die von den meisten Collection-Implementierungen bereitgestellt wird. Alternativ lassen sich auch Methoden wie Stream.of(...) , Arrays.stream(...) oder IntStream.range(...) nutzen, um Stream-Instanzen zu erzeugen. Unabhängig von der Quelle entsteht dabei stets eine Pipeline, die potenziell verzögert ausgewertet wird.

Sobald ein Stream initialisiert ist, lassen sich Intermediate Operations wie filter , map oder sorted anwenden, um den Datenfluss zu transformieren oder zu verfeinern. Diese Operationen sind rein beschreibend und verändern weder die ursprüngliche Datenquelle noch lösen sie eine Berechnung aus. Sie bauen vielmehr eine Art Rezept auf, das eine Terminal Operation später ausführt.

Der Abschluss der Pipeline erfolgt demnach durch eine Terminal Operation, die die Ausführung auslöst und das Ergebnismaterial liefert. Erst zu diesem Zeitpunkt wird die Pipeline evaluiert und dabei alle vorher definierten Schritte in einem Durchlauf auf die Daten angewendet. Dies ist ein zentraler Unterschied zur herkömmlichen Verarbeitung mittels Schleifen oder Iteratoren, bei denen jeder Verarbeitungsschritt sofort erfolgt.

Gerade zu Beginn ist es hilfreich, mit einfachen Beispielen zu experimentieren, etwa durch Filtern von Zeichenketten oder Transformation von Ganzzahlen. Dies vermittelt ein intuitives Verständnis des Datenflusses, der Verkettung von Operationen und der zugrundeliegenden Ausführungslogik. Dabei zeigt sich schnell der Vorteil von Streams: Sie fördern eine prägnante, lesbare und gleichzeitig effiziente Ausdrucksweise für datengetriebene Operationen, ohne die Struktur des zugrundeliegenden Codes unnötig zu verkomplizieren.

Die Kraft der Komposition

Die Stärke der Stream-API in Java liegt nicht allein in ihrer Fähigkeit, Daten deklarativ zu verarbeiten, sondern vor allem in der Möglichkeit, komplexe Verarbeitungsschritte zu einer einheitlichen Komposition zu formen. Streams erlauben es, Transformations- und Filterlogik modular zu definieren und elegant zu kombinieren, wodurch sich auch komplexe Datenflüsse nachvollziehbar und wiederverwendbar gestalten lassen. Die zugrundeliegende Idee ist es, Rechenoperationen als Funktionseinheiten zu verstehen, die sich fließend zu einer Verarbeitungskette zusammenfügen lassen.

Aus Sicht der Softwarearchitektur eröffnet die Komposition von Streams einen eleganten Weg zur Modularisierung von Verarbeitungsschritten. So lassen sich etwa Methoden definieren, die eine bestimmte Stream-Transformation kapseln und selbst wiederum als Baustein in eine größere Pipeline eingebettet werden können. Durch die Nutzung von Higher-Order Functions, beispielsweise durch Rückgabe eines Function -Objekts, entsteht ein Repertoire an wiederverwendbaren Verarbeitungsmodulen, das sich dynamisch zusammenstellen lässt. Dies fördert nicht nur die Lesbarkeit, sondern auch die Testbarkeit und Wartbarkeit des Codes.

Ein weiterer Vorteil liegt in der klaren Trennung von Struktur und Verhalten. Während imperativer Code typischerweise Schleifenlogik mit Fachlogik vermischt, erlaubt die Stream-Komposition eine entkoppelte Betrachtung: Die Art des Datenflusses (z. B. sequenziell oder parallel) ist orthogonal zur Frage, was inhaltlich mit den Daten geschieht. Diese Trennung erleichtert es, bestehende Pipelines in unterschiedlichen Kontexten wiederzuverwenden oder gezielt zu erweitern, ohne deren Struktur grundlegend verändern zu müssen.

Nicht zuletzt ist auch die Kombination verschiedener Stream-Typen ein Ausdruck dieser Kompositionsfähigkeit. So lassen sich primitive Streams ( IntStream , LongStream , DoubleStream ) mit Objektstreams über Konvertierungsmethoden wie boxed() oder mapToInt() verbinden. Ebenso lässt sich über flatMap die Verarbeitung verschachtelter Datenstrukturen realisieren, wobei aus einem Stream von Containern ein Datenstrom entsteht, der die Containerinhalte umfasst und sich nahtlos weiterverarbeiten lässt.

Die Fähigkeit, Streams zu komponieren, ist damit mehr als eine syntaktische Annehmlichkeit. Sie repräsentiert einen fundamentalen Paradigmenwechsel in der Art, wie in Java Datenflüsse entworfen, strukturiert und ausgeführt werden. Wer diesen Ansatz beherrscht, kann selbst komplexe Anwendungslogik in klar strukturierte, funktional geprägte Module überführen – ein Gewinn sowohl in Bezug auf Wartbarkeit als auch auf Ausdruckskraft.

Auswirkungen auf die klassischen Design-Pattern in Java

Die Integration der Stream-API in Java hat tiefgreifende Auswirkungen auf den Einsatz und die Notwendigkeit klassischer Design-Patterns. Viele Muster in der objektorientierten Entwicklung entstanden als Antwort auf das Fehlen funktionaler Ausdrucksmittel. Mit dem Aufkommen von Streams und ihrer engen Verzahnung mit funktionalen Konzepten wie Lambdas und Higher-Order Functions verändert sich jedoch die Rolle dieser Muster fundamental. Besonders auffällig wird dies bei Patterns, die ursprünglich zur Steuerung von Iteration, Transformation oder Filterung von Datenstrukturen dienten.

Ein prominentes Beispiel hierfür ist das Iterator Pattern, das durch Streams weitgehend obsolet geworden ist. Während das Iterator Pattern in klassischem Java als idiomatischer Zugang zur sequenziellen Verarbeitung von Collections galt, kapselt die Stream-API diese Verantwortung vollständig. Der Zugriff auf die Elemente erfolgt implizit und deklarativ, die Reihenfolge sowie das Traversierungsverhalten werden durch die Stream-Konfiguration gesteuert. Die manuelle Kontrolle über die Iteration, im Sinne des Patterns, wird somit durch eine ausdrucksstärkere und zugleich weniger fehleranfällige Abstraktion ersetzt.

Auch das Strategy Pattern erfährt durch Streams eine Transformation. Strategien, die früher als separate Klassen oder Interfaces mit konkreten Implementierungen programmiert wurden, lassen sich heute elegant über Lambdas und methodenbasierte Komposition innerhalb von Stream-Pipelines realisieren. Filter- oder Mapping-Strategien, die zuvor durch objektorientierte Vererbungshierarchien modelliert wurden, lassen sich nun inline definieren und dynamisch kombinieren – eine Veränderung, die nicht nur den Sourcecode vereinfacht, sondern auch dessen Flexibilität erhöht.

Das Decorator Pattern, traditionell verwendet zur dynamischen Erweiterung von Funktionalität durch geschachtelte Objektstrukturen, findet in der Stream-Welt eine moderne Entsprechung in der Verkettung von Intermediate Operations. Jede Operation transformiert den Stream und fügt eine weitere Verarbeitungsschicht hinzu – allerdings nicht durch Vererbung oder Objektzusammensetzung, sondern durch funktionale Pipeline-Elemente. Die resultierende Struktur ist nicht nur kompakter, sondern erlaubt auch eine wesentlich dynamischere Konfiguration zur Laufzeit.

Darüber hinaus wirft die Stream-Architektur ein neues Licht auf das Template Method Pattern. Während dieses ursprünglich dazu diente, die Struktur eines Algorithmus zu definieren und variierende Schritte in Unterklassen zu implementieren, ermöglicht die Stream-API die Definition solcher "Algorithmen" über methodisch kombinierte Funktionen. Die festen Verarbeitungsschritte werden durch die Sequenz der Stream-Operationen vorgegeben, während konkrete Schritte durch übergebene Funktionen spezifiziert sind. In der Folge ist das Verhalten modularer und von statischer Vererbung entkoppelt.

Schließlich verändern Streams auch das Verständnis von Patterns wie Chain of Responsibility oder Pipeline. Der Zweck dieser Muster ist es, flexible Verarbeitungssequenzen zu modellieren, bei denen jedes Element optional agiert und die Verantwortung weiterreichen kann. Stream-Pipelines realisieren dieses Prinzip auf funktionaler Ebene, wobei jede Intermediate Operation einer "Verarbeitungseinheit" entspricht. Der große Unterschied besteht darin, dass keine Objekte manuell miteinander verkettet werden müssen; stattdessen ergibt sich die Verarbeitungskette aus der fließenden (fluenten) Syntax der API selbst.

Zusammenfassend lässt sich festhalten, dass Streams in Java zu einer funktionalen Neukontextualisierung klassischer Design Patterns führen. Viele Muster werden dadurch nicht überflüssig, wohl aber in ihrer Umsetzung transformiert. Sie erscheinen nun weniger als starre Klassenstrukturen, sondern vielmehr als dynamische, konfigurierbare Einheiten, die sich nahtlos in fluente APIs einfügen. Für Entwicklerinnen und Entwickler eröffnet dies nicht nur neue Ausdrucksmöglichkeiten, sondern auch ein reflektiertes Verständnis davon, wann ein Pattern im klassischen Sinn überhaupt noch erforderlich ist. Darauf werde ich in einem gesonderten Beitrag näher eingehen.

Ein Beispiel zum Übergang von klassischem Java hin zum Verwenden von Streams

Ein klassischer Algorithmus zur Datenverarbeitung in Java ist das Extrahieren, Transformieren und Aggregieren von Informationen aus einer Liste komplexer Objekte. Als Beispiel soll eine Liste von Person -Objekten dienen, die jeweils Name, Alter und Wohnort enthalten. Ziel ist es, alle Namen der volljährigen Personen zu extrahieren, alphabetisch zu sortieren und als durch Komma getrennte Zeichenkette zurückzugeben. Die klassische imperativ-objektorientierte Umsetzung dieser Anforderung erfolgt in Java typischerweise über explizite Schleifen, temporäre Listen und manuelle Kontrollstrukturen.

Eine solche Implementierung beginnt meist mit dem Erzeugen einer neuen Ergebnisliste. Anschließend wird über die Ursprungsdaten iteriert, wobei eine if -Bedingung prüft, ob das Alter der jeweiligen Person über 17 liegt. Ist dies der Fall, wird der Name der Person zur Ergebnisliste hinzugefügt. Nach Abschluss der Iteration lässt sich die Liste durch einen expliziten Aufruf der Sortiermethode alphabetisch sortieren. Abschließend wird die Liste mittels einer Schleife oder durch den Einsatz eines StringBuilder in eine kommagetrennte Zeichenkette umgewandelt. Dieser Ansatz funktioniert korrekt, erfordert jedoch eine Vielzahl an Zwischenschritten und führt leicht zu redundanter oder fehleranfälliger Logik – etwa beim Sortieren oder beim Formatieren des Ergebnisses.

Dank der Stream-API lässt sich derselbe Algorithmus deutlich prägnanter und deklarativer ausdrücken. Der gesamte Datenfluss – von der Filterung über die Transformation bis hin zur Aggregation – lässt sich in einer einzigen Ausdruckseinheit modellieren. Der Stream wird von der Liste abgeleitet, anschließend sortiert eine filter -Operation die volljährigen Personen heraus, bevor eine nachfolgende map -Transformation die Namen extrahiert. Das Sortieren übernimmt die Funktion sorted , und die abschließende Aggregation erfolgt über Collectors.joining(", ") . Der gesamte Algorithmus lässt sich somit in einer fluenten, klar strukturierten Pipeline ausdrücken, deren Teilschritte durch ihre Methodennamen semantisch selbsterklärend sind.

Die Unterschiede zwischen den beiden Ansätzen sind sowohl syntaktischer als auch konzeptioneller Natur. Während die klassische Lösung imperatives Denken voraussetzt und jedes Verarbeitungselement manuell steuert, erlaubt der Stream-Ansatz eine deklarative Modellierung des "Was" und überlässt das "Wie" der Ausführung der Laufzeitumgebung. Diese Abstraktionsebene fördert nicht nur die Lesbarkeit, sondern auch die Wartbarkeit des Codes, da Entwickler sich auf die fachliche Logik konzentrieren können, ohne dass Kontrollflusskonstrukte sie ablenken.

Es zeigt sich darüber hinaus, dass Streams auch eine semantische Verdichtung ermöglichen. Ein Algorithmus, der zuvor mehrere Dutzend Zeilen beanspruchte, reduziert sich in der Regel auf wenige klar strukturierte Funktionsaufrufe. Diese Kompaktheit geht jedoch nicht zu Lasten der Transparenz – im Gegenteil: Durch die sprechenden Methodennamen und die fluente Struktur ist der Datenfluss explizit nachvollziehbar. Die Stream-Variante wirkt daher nicht nur moderner, sondern auch konzeptionell näher an der Problemstellung.

Es lässt sich festhalten, dass die Stream-basierte Umsetzung funktionale Prinzipien in die Java-Welt integriert, ohne deren Typsicherheit oder Objektorientierung aufzugeben. Sie ermöglicht es, klassische Algorithmen mit einem neuen Abstraktionsniveau zu formulieren, das nicht nur den Code vereinfacht, sondern auch dessen Intention klarer zum Ausdruck bringt. Im Weiteren lässt sich das anhand des Quelltexts zum Beispiel nachvollziehen. Die folgenden Strukturen müssen dazu für beide Implementierungen zur Verfügung stehen:

record Person(String name, int age, String city) {} private static final List PEOPLE = List.of( new Person("Alice", 23, "Berlin"), new Person("Bob", 16, "Hamburg"), new Person("Clara", 19, "München"), new Person("David", 17, "Köln") );

Beispiel 1: Klassisches Java ohne Streams

List adultNames = new ArrayList<>(); for (Person p : PEOPLE) { if (p.age >= 18) { adultNames.add(p.name); } } Collections.sort(adultNames); StringBuilder result = new StringBuilder(); for (int i = 0; i < adultNames.size(); i++) { result.append(adultNames.get(i)); if (i < adultNames.size() - 1) { result.append(", "); } } System.out.println("Ergebnis: " + result); }

In der klassischen Variante ist der Datenfluss fragmentiert und verteilt über mehrere Schritte: Filtern, Sammeln, Sortieren und Formatieren erfolgen in separaten Abschnitten, teilweise unter Einsatz temporärer Strukturen. Das führt zu erhöhter Komplexität und potenziellen Fehlerquellen – etwa bei der korrekten Formatierung des Ausgabestrings.

Beispiel 2: Java unter Verwendung der Stream-API

public static void main(String[] args) { String result = PEOPLE.stream() .filter(p -> p.age() >= 18) .map(Person::name) .sorted() .collect(Collectors.joining(", ")); System.out.println("Ergebnis: " + result); }

Die Stream-Variante hingegen drückt den gesamten Datenverarbeitungsprozess in einer einzigen Pipeline aus. Jeder Verarbeitungsschritt ist klar benannt, die Transformation erfolgt fließend, und das Ergebnis ist unmittelbar ablesbar. Besonders hervorzuheben ist die bessere Lesbarkeit, die Reduzierung von Nebenwirkungen und die Erweiterbarkeit – zusätzliche Verarbeitungsschritte lassen sich durch einfaches Einfügen weiterer Operationen in die Pipeline ergänzen, ohne die Struktur grundlegend zu verändern.